GPU NVIDIA chứng minh bài toán 10.000 năm có thể giải được, thách thức sức mạnh lượng tử của Google

Nhóm nghiên cứu sử dụng 1.432 GPU Nvidia A100 để mô phỏng mạch lượng tử Sycamore, thách thức tuyên bố "ưu thế lượng tử" của Google.

Một nhóm các nhà nghiên cứu vừa tạo nên một dấu mốc quan trọng trong lĩnh vực điện toán lượng tử, khi thành công mô phỏng lại mạch lượng tử Sycamore 53-qubit của Google chỉ với sự hỗ trợ của 1.432 GPU Nvidia A100. Sự kiện này không chỉ chứng minh khả năng vượt trội của công nghệ điện toán cổ điển hiện đại, mà còn đặt dấu hỏi lớn về tuyên bố "ưu thế lượng tử" mà Google từng công bố vào năm 2019.

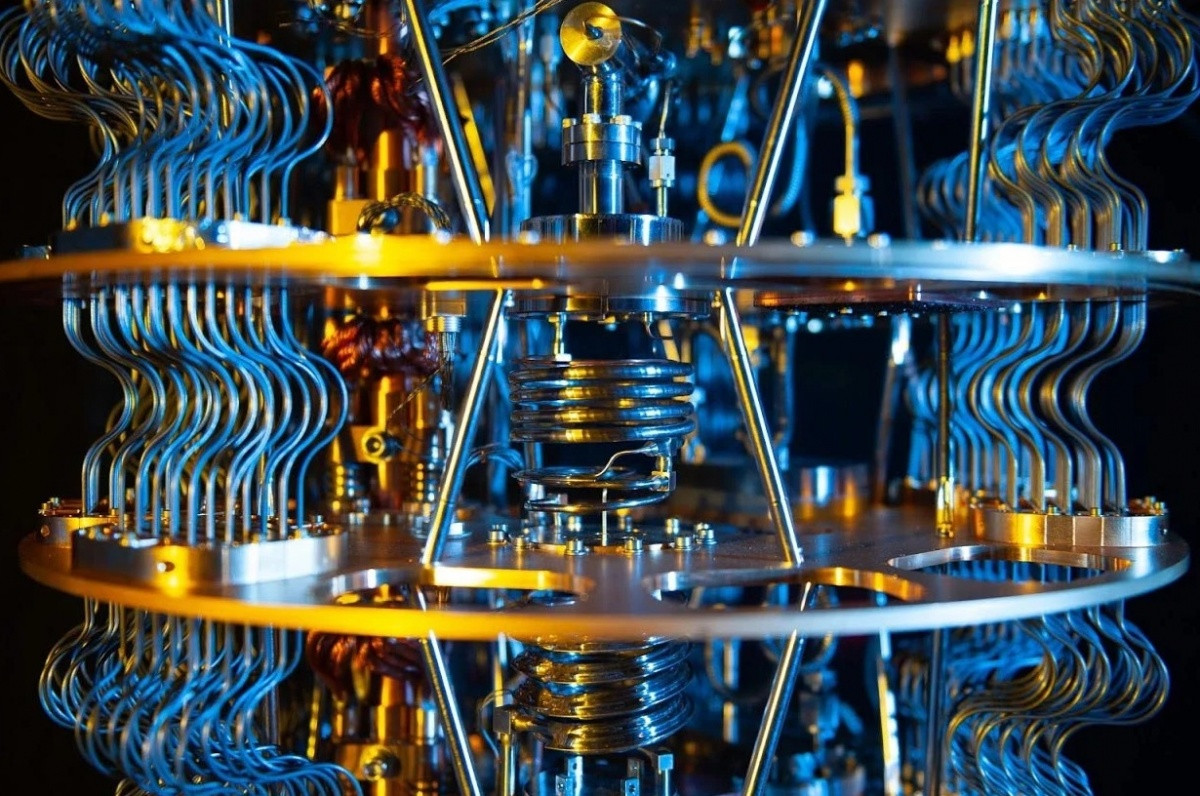

Vào thời điểm đó, Google từng khẳng định rằng siêu máy tính mạnh nhất thế giới sẽ phải mất tới 10.000 năm để giải quyết bài toán mà máy lượng tử Sycamore có thể xử lý chỉ trong vài phút. Tuy nhiên, với bước tiến lần này, nhóm nghiên cứu đã cho thấy chỉ cần tối ưu thuật toán kết hợp cùng hạ tầng GPU hiện đại, thời gian cần thiết để mô phỏng kết quả lượng tử có thể rút ngắn đáng kể, làm lung lay niềm tin tuyệt đối vào sự "vượt trội không thể chối cãi" của máy tính lượng tử.

|

| Máy lượng tử Sycamore có thể xử lý bài toán chỉ trong vài phút. Ảnh: Internet |

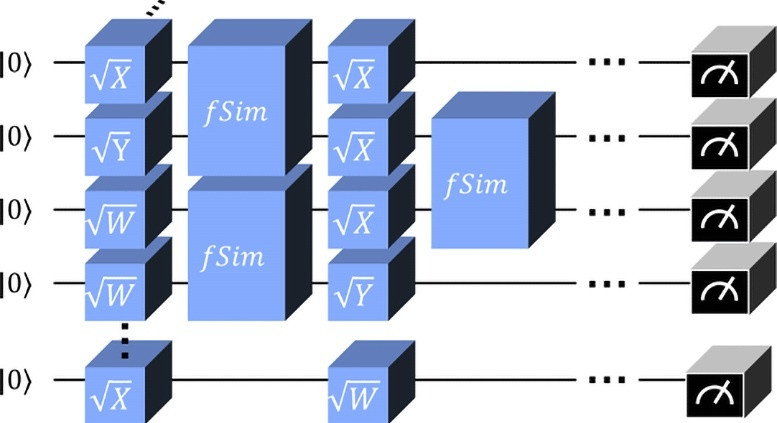

Cốt lõi thành công của nhóm nghiên cứu nằm ở việc sử dụng các kỹ thuật co mạng tensor tiên tiến. Thay vì xử lý toàn bộ khối lượng dữ liệu khổng lồ, họ đã áp dụng chiến lược slicing, chia nhỏ mạng tensor thành nhiều phần dễ quản lý hơn. Nhờ đó, yêu cầu bộ nhớ được giảm mạnh mà hiệu suất tính toán vẫn duy trì ở mức tối ưu. Cùng với đó, phương pháp lấy mẫu "top-k" được triển khai, chỉ tập trung vào những chuỗi bit có xác suất cao nhất, vừa cải thiện độ chính xác của kết quả, vừa tiết kiệm đáng kể tài nguyên tính toán.

|

| Thay vì xử lý toàn bộ khối lượng dữ liệu khổng lồ, họ đã áp dụng chiến lược slicing, chia nhỏ mạng tensor thành nhiều phần dễ quản lý hơn. Ảnh: Internet |

Điều đáng chú ý là nhóm nghiên cứu đã xác minh độ tin cậy của thuật toán bằng các thử nghiệm mô phỏng mạch ngẫu nhiên quy mô nhỏ hơn. Trong các bài kiểm tra với mạch 30-qubit, kết quả thu được cho thấy mức độ phù hợp tuyệt vời với các dự đoán lý thuyết, khẳng định hiệu quả và độ chính xác của cách tiếp cận mới.

Không dừng lại ở việc mô phỏng thành công, nhóm nghiên cứu còn đưa ra các chiến lược tối ưu hóa sâu hơn, từ việc sắp xếp chỉ số tensor hợp lý cho đến giảm thiểu giao tiếp giữa các GPU, giúp tăng hiệu quả tính toán tổng thể. Những phân tích độ phức tạp cũng chỉ ra rằng nếu sở hữu dung lượng bộ nhớ lớn hơn, ví dụ như 640GB hay thậm chí 5120GB, tốc độ mô phỏng còn có thể được cải thiện vượt bậc.

Dù vậy, các chuyên gia cũng nhấn mạnh rằng thành tựu này không có nghĩa là máy tính cổ điển có thể thay thế hoàn toàn máy tính lượng tử. Khi số lượng qubit tăng lên, từ 53 đến 100 hoặc nhiều hơn, dung lượng bộ nhớ và tài nguyên cần thiết cho mô phỏng cổ điển sẽ tăng theo cấp số nhân. Mỗi qubit bổ sung khiến không gian trạng thái cần xử lý tăng gấp đôi, đẩy bài toán ra ngoài khả năng chịu tải của các hệ thống hiện tại.

Bên cạnh đó, những thuật toán chuyên biệt dành riêng cho máy tính lượng tử như thuật toán Shor hay Grover vẫn chứng minh được khả năng vượt trội so với bất kỳ phương pháp cổ điển nào. Điều đó có nghĩa là, dù các tiến bộ trong mô phỏng cổ điển rất ấn tượng, tiềm năng dài hạn của điện toán lượng tử trong việc giải quyết các bài toán siêu khó vẫn còn nguyên vẹn.

Thành tựu lần này không chỉ thách thức trực tiếp tuyên bố của Google, mà còn mở ra hướng phát triển mới cho điện toán cổ điển và lượng tử. Sự kết hợp giữa sức mạnh phần cứng GPU hiện đại với thuật toán tối ưu hóa thông minh hứa hẹn sẽ thúc đẩy nhiều bước tiến đột phá hơn nữa trong tương lai gần, cả trong mô phỏng lượng tử và ứng dụng vào các lĩnh vực khoa học khác.

>> Bạn đang bị Chrome thu thập dữ liệu mà không hề hay biết?